Topics

- Machine Learning

- 선형대수

- 확률

Machine Learning

1. Machine Learning 정의

간단히 요약하자면 데이터에서 지식을 추출하는 것을 Machine 이 스스로 할 수 있도록 학습하는 것이다. 데이터 내부에 존재하는 특징과 패턴들을 찾는 것을 스스로 할 수 있도록 하는 것이다. 여기서 특징과 패턴들을 Feature 라고 부른다.

인공지능 (AI) 과 ML, DL 의 차이와 발전되는 방향은 다음과 같다.

AI : 기계가 사람처럼 생각하고 행동하면 좋겠다.. How?

-> ML : 학습을 통해서 사람처럼 생각하여 예측을 진행해야겠다.. How?

-> DL : 그렇다면 사람의 인지 과정을 모방해보자!

ML은 명시적 프로그램인 Rule-Based Expert System 에서 발전된 형태이다.

| Rule-Based Expert System | Machine Learning | |

| 정의 | 문제 해결 Rule 을 수동으로 사전에 정의 | 데이터 내부에서 자주 발생하는 특징과 패턴을 감지 |

| 장점 | 사람이 이해하기 쉬움 | 전문가가 필수적으로 필요하지는 않음 |

| 단점 | 규칙 설계 시 전문가의 도움 필요 변경 Hard 특정 분야에 국한됨 |

다양한 데이터가 필요 |

2. Machine Learning Loadmap

문제 정의 (파이프라인, 모델 입/출력) -> 데이터 확인 (시각화, 특성 파악) -> 데이터 분할 (학습, 검증, 테스트 데이터 분할, 편향성, 이상치 제거) -> 알고리즘 탐색 (선행 연구, 프로젝트 참고) -> 데이터 전처리 (알고리즘 고려, 선행 과정 참고) -> 최종 테스트 (테스트 데이터 활용, 보고) -> 시스템 런칭

여기서 주의해야 할 것은 최종 테스트 단계에서 잘못된 부분이 존재한다면 그 전의 단계나 다른 단계로 돌아갈 수 있으므로 단계별로 진행할 때 놓친 것은 없는지 꼼꼼하게 확인하면서 진행하는 것이 좋음.

선형대수

선형대수를 설명하기 전, Meta data와 Label 간의 유사성에 대해서 언급함. Meta data 는 데이터를 설명해주는 정보로서, 데이터의 관계와 구조를 파악하고 내용을 설명하는 정보이다. Label 은 특정 문제에 해당하는 데이터의 설명 혹은 답변으로, 분류와 관련된 문제라면 범주를 파악하고 목표 값으로 회귀하려는 문제라면 숫자를 특정하는 것이다.

학습 방법

| Supervised Learning | UnSupervised Learning | Semi-Supervised Learning | Self-Supervised Learning | Reinforcement Learning | |

| 정의 | 정답 label 존재, 이를 활용하여 알고리즘 학습 | 정답 label 존재하지 않고 오직 입력 데이터만 존재 | 일부만 정답 label 존재. | 정답 label 존재하지 않아 강제로 생성 후 학습. 주로 데이터 내부를 강제로 훼손 후 복원 방법 사용 | 특정 행동을 유도하도록 학습함. |

| 목적 | Data label - 정답 label 관계 파악 |

스스로 패턴을 파악하려는 목적 | 정답이 있는 것과 아닌 것을 구분하여 전체 데이터 패턴을 파악. | 데이터 내부 성질 파악 | - |

| 장점 | 정답이 존재하여 비교적 학습 용이, 모델의 성능 파악에 용이함. | 사용자가 의도한 패턴 외 다른 새로운 패턴을 찾을 수 있음. | 정답 label 이 부족한 dataset 에 유용함. | label 없이 데이터 특징 파악 가능 | |

| 단점 | 정답을 만들기 위한 추가적인 시간과 노력, 비용 소모 | 정답, 즉 기준이 없어 결과가 주관적일 수 있음. 신뢰성을 얻으려면다양한 데이터 필요 |

데이터의 품질 문제, 알고리즘의 복잡성 문제 | 잘못된 패턴 학습 가능성 존재, N회 이상 학습이 필요. |

선형대수란, 수의 연산을 빠르고 효율적으로 하기 위한 도구로서, 기하학적으로 수의 집합을 표현하여 보기 쉽게 파악이 가능하도록 한다.

수의 집합

| Scalar | Vector | Matrix | Tensor | |

| 정의 | 차원이 없는 단순한 숫 자 | 1차원, 한쪽 방향 | 2차원 | 3차원 이상 (벡터와 행렬 일반화) |

행렬 연산

- 덧셈, 뺄셈은 같은 크기에만 각 원소끼리 가능함.

- 곱셈은 행과 열 간의 내적 -> 행과 열의 크기가 같아야 가능함. (내적 : 벡터 간 연산)

- 수의 곱셈은 다른 말로 "Hadamard product"

- 행과 열을 바꾼 행렬은 Transpose Matrix

- det(A) = 0이 아님 <=> A : 가역행렬 <=> 특이행렬 X

det(A) = 0 <=> A : 비가역행렬 <=> 특이행렬 O

-> AB = I -> B = A^(-1)

따라서, AA^(-1) = I,,

고유벡터와 고유값

Linear Transformation 은 벡터의 방향과 크기를 변경하는 것.

AV = ΛV -> 벡터의 크기만 변경함.

V : 고유 벡터 => Matrix A가 가장 많이 분산되는 방향 => 정보가 가장 많음 => 데이터의 의미가 가장 큼.

Λ : 고유값 => 분산의 크기

단, 정방 행렬일 때만 고유값, 고유벡터를 구할 수 있음.

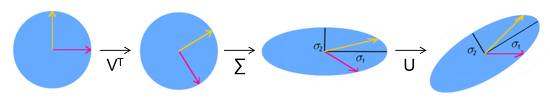

SVD (Singular Value Decomposition)

A = UΣV^(T)

< U, V : 직교행렬, Σ : 대각행렬 >

U : m x m

V : n x n

A : m x n

여기서 만들어지는 대각행렬은 중요한 스케일링 정보를 포함하고 있음. -> Scale transformation직교행렬의 기하학적인 의미는 rotation transformation or reflected rotation transformation.

확률

확률이란, 특정한 사건이 일어날 가능성을 의미함.

P(X) = 특정한 확률 변수 X가 일어날 확률

- 합의 법칙 : A ∩ B = 0, (A , B)

'Bootcamp' 카테고리의 다른 글

| [Week 11] Day 2 - TIL (1) | 2024.02.06 |

|---|---|

| [Week 11] Day 1 - TIL (0) | 2024.02.05 |

| [Week 8] Day 4 - TIL (4) | 2024.01.12 |

| [Week 8] Day 1 - TIL (2) | 2024.01.08 |

| [Week 7] Day 1 - TIL (1) | 2024.01.06 |